参与:李泽南

9 月 26 日上午,英伟达 GTC 大会中国站在北京开幕。作为每年 GPU 开发者最为重要的盛会,GTC 和全球一系列活动为开发者们提供了宝贵的培训机会。同时,大会上也展出了当今计算行业最重要的研究成果,涉及领域包括人工智能、深度学习、医疗保健、虚拟现实、加速分析和自动驾驶汽车。在黄仁勋上午的 Keynote 演讲中,我们看到了英伟达和整个业界在人工智能领域的最新进展。作为 GTC 特邀媒体,机器之心亲临大会现场,第一时间对本次大会的亮点进行了报道。

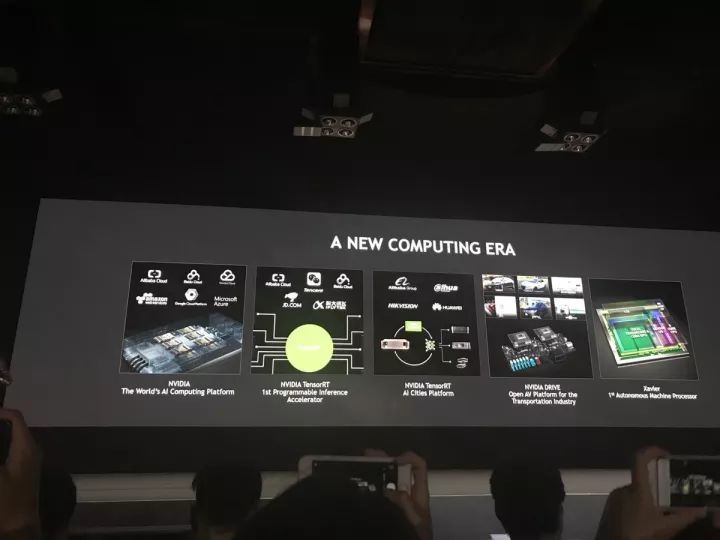

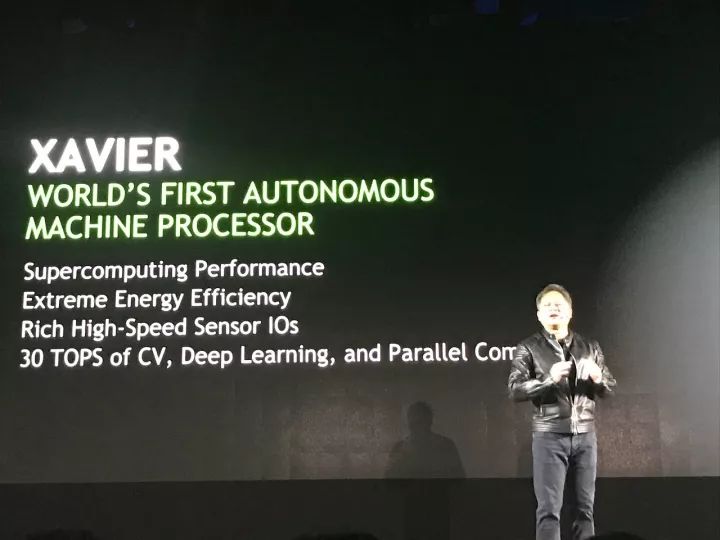

本次 GTC 大会上不乏重要新闻,除了新版优化引擎 TensorRT 3.0 以外,英伟达还宣布与国内 OEM 厂商展开合作,准备共同推出基于 Tesla V100 的 HGX-1 加速器;同时宣布全球首款自动机器处理器 Xaiver,正在与京东合作,共同探索无人机和送货机器人等设备的发展。

大会 Keynote 亮点:

-

发布 TensorRT3 深度学习引擎;

-

全球首款自动机器处理器 Xavier;

-

一系列产业合作。

TensorRT3 深度学习引擎

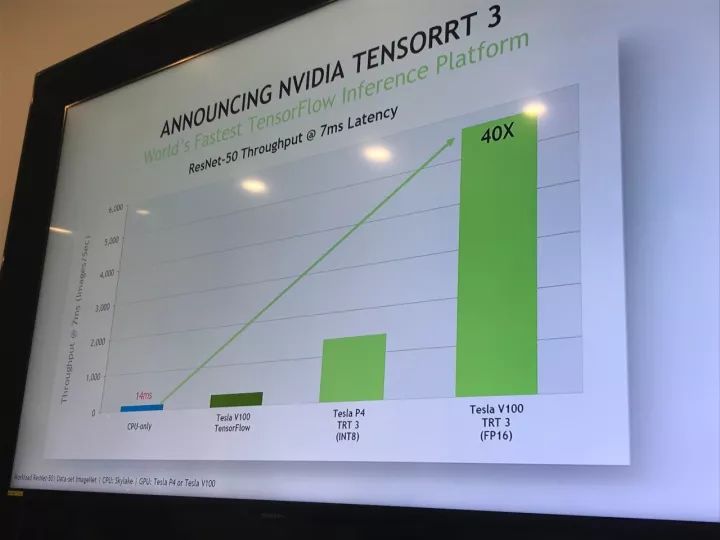

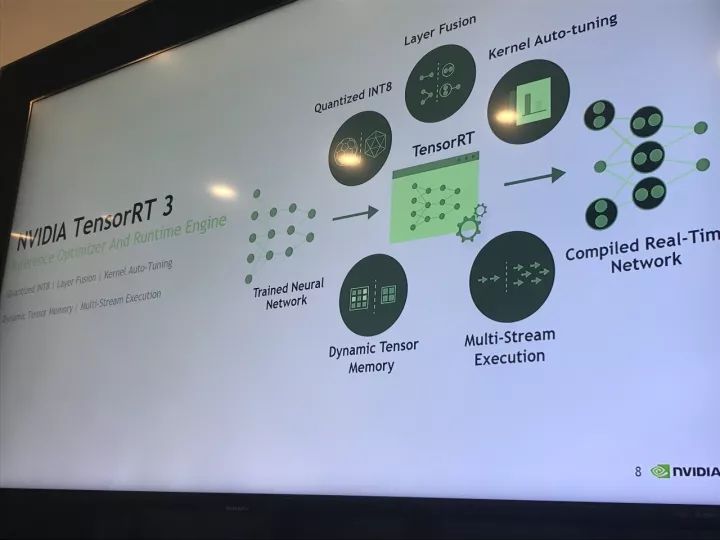

在本次大会中,最为引人关注的就是正式发布的 TensorRT 3.0 了。黄仁勋在大会上花费了大量篇幅对其进行了详细介绍。「深度学习推理引擎」TensorRT 是连接神经网络框架和硬件(GPU)平台的桥梁,它的支持范围覆盖终端设备芯片到服务器级别的各种芯片。由于英伟达的硬件优势,TensorRT 可以将神经网络计算的延迟降低至业内最低水平,这对于面向消费者的应用级产品而言非常重要。

在使用 TensorRT 3.0 之后,ResNet-50 处理图像的速度是 CPU 的 40 倍。

英伟达宣称,新的 TensorRT 3.0 已经支持所有种类的流行神经网络框架(包括 TensorFlow、Microsoft Cognitive Tookit、MXNet、PyTorch、Caffe2、PaddlePaddle 与 Theano),并覆盖支持更多种类的 GPU(包括最近推出的 Jetson TX2 与 Tesla V100)。在过去主要面向于图像处理任务的基础上,英伟达的持续开发让 TensorRT 支持了更多的应用和神经网络种类。作为一个可编程的通用平台,TensorRT 让 GPU 相对其他硬件有了更多优势。

「人工智能在过去的一年里发展很快,但是我们面临的挑战仍然很多,」英伟达人工智能产品负责人 Han Vanholder 表示,「目前我们使用的服务器架构不是为人工智能任务设计的,在这种情况下,如果想完成一种语音识别服务,我们就需要(基于 CPU 的传统服务器)用到价值 10 亿美元的服务器组,而它的功率是 100MW——而这只是用于一种服务的数字。」

除了速度和效率,对于开发者而言,TensorRT 也是一种易于使用的工具。英伟达表示,很多人工智能研发团队在使用中发现,用其他的解决方案可能需要几周,几月才能实现的深度学习项目(需要修改代码、进行编译、测试),在使用 TensorRT 的情况下只需要一天的时间就可以看到结果了,由于高度集成的特性,开发者在实现自己的想法时不需要调整大量手动设置。

「这样就可以让你更加关注与产品本身相关的东西了,」黄仁勋在演讲中说道,「而不是在优化和兼容性上消耗时间。」

将 HGX-1 加速器引入中国

在 GTC 大会上,英伟达也宣布了一系列与国内相关的合作项目。其中,将搭载最新架构 Tesla V100 芯片的 HGX-1 带入中国值得注意。在上午的大会上,黄仁勋宣布,英伟达正在与华为、浪潮、联想等公司展开合作,准备共同推出基于 Tesla V100 芯片的 HGX-1 加速器。希望使用这些技术的用户,可以在近期获得有这些公司生产的 OEM 产品。

高性能计算设备(HPC)是现代科学的基础,从预测天气、发明新药到寻找新能源,大型计算系统能为我们模拟和预测世界的变化。这也是英伟达在新一代 GPU 架构推出时选择优先发布企业级计算卡的原因。在今年五月,英伟达发布全新 Volta 架构时,首先推出的就是专为 HPC 和 AI 的融合而设计的 Tesla V100 计算卡。目前,它主要整合在 HGX-1 加速器中被使用。

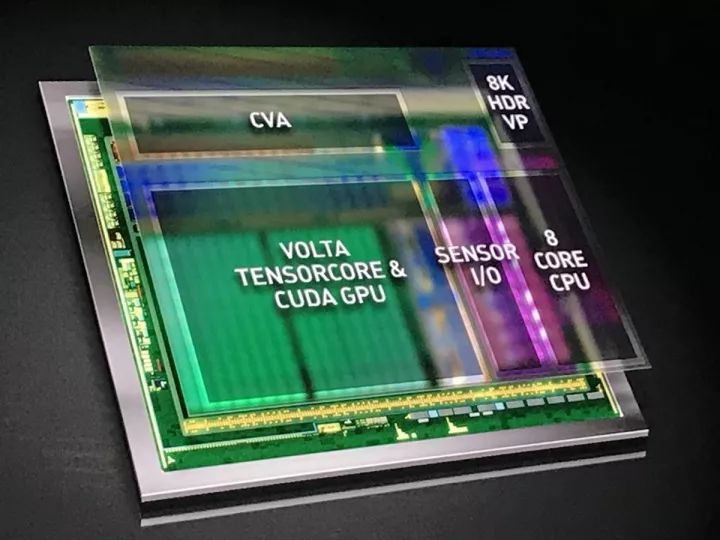

全新的 Tensor Core 设计是 Volta V100 最重要的特征,它有助于提高训练神经网络所需的性能。Tesla V100 的 Tensor Core 能够为训练、推理应用的提供 120 Tensor TFLOPS。相比于在 P100 FP 32 上,在 Tesla V100 上进行深度学习训练有 12 倍的峰值 TFLOPS 提升。而在深度学习推理能力上,相比于 P100 FP16 运算,有了 6 倍的提升。Tesla V100 GPU 包含 640 个 Tensor Core:其中每个流式处理器(SM)有 8 个。

矩阵-矩阵乘法运算(BLAS GEMM)是神经网络训练和推理的核心,被用来获得输入数据和权重的大型矩阵的乘积。如下图 6 所示,相比于基于 Pascal 的 GP100,Tesla V100 中的 Tensor Core 把这些运算的性能提升了至少 9 倍。

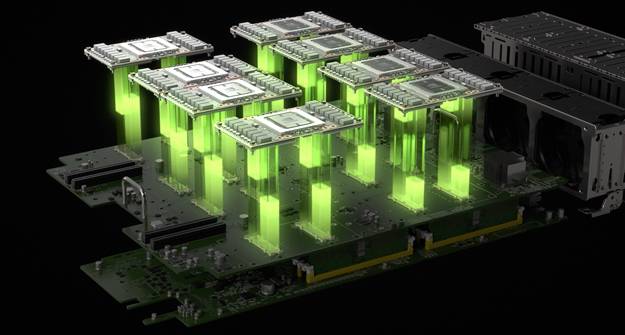

加速器内含 8 块 Tesla V100 芯片(外加必要的 CPU 等芯片),英伟达宣称其性能相当于 150 块 CPU 的和(在语音识别、图像识别等任务中)。它通过 NVlink 高效并联了 8 块 GPU 的计算能力,通过 PCIe 交换架构,HGX-1 也可以动态链接任意数量的 GPU。这样以来,一台 HGX-1 就可以为用户提供足够的 CPU 和 GPU 应用。英伟达宣称,在深度学习任务中,HGX-1 与传统基于 CPU 的服务器相比,性能可以提升 100 倍,人工智能训练任务的花费为后者的 1/5,AI 推算的十分之一。黄仁勋表示,每台 V100 服务器可以为客户节省 50 万美元的成本。

「科大讯飞、微信、京东、阿里巴巴等公司都已经在使用英伟达的最新产品了。」黄仁勋介绍道。「对于这些公司来说,搭载 Volta 芯片的服务器让自己获得了先机。如果在手机 APP 上,一项服务的延迟有一秒钟的话,用户会感到不耐烦,倾向于转而使用其他服务。对于阿里巴巴来说,在使用了英伟达的技术和硬件之后,他们获得了满意的效果。」

在本次大会上,英伟达也已宣布自己已经开始与阿里云、百度云、腾讯云等平台展开合作,将搭载新一代 Tesla V100 芯片的服务器大规模投入使用。

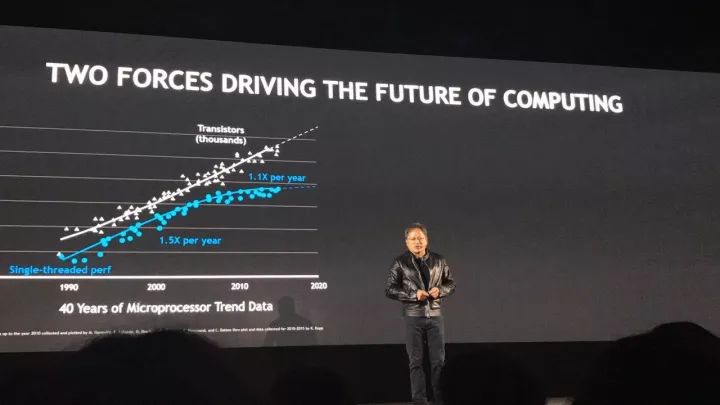

「摩尔定律已经是过时的定律了,」黄仁勋表示,」它是一种缓慢增长的定律,GPU 的计算能力发展速度超过了摩尔定律,神经网络的性能发展也超过了摩尔定律。我们将这两者结合,可以创造更加美好的未来。」

全球首款智能机器处理器 Xavier

英伟达认为,AI 技术、用户场景(关系到数据)和计算能力,促成了首批 AI 先锋公司。作为芯片供应商,这家公司希望与所有致力于拓展 AI 前沿的公司展开合作。

京东选择了英伟达的支持在无人机/机器人平台上提供计算能力。京东称在 2022 年将会部署 100 万台无人机用于物流。无论使用什么样的 GPU,TensorRT 都可以进行很好的支持。

在大会上,英伟达展示了搭载 Volta 芯片的新一代终端芯片 Xavier,并宣布该芯片将会出现在下一代 Jetson 系统上,自 2018 年一季度起为京东的物流机器人与无人机率先提供支持。而大规模供货需要等到 2018 年四季度。

扫一扫关注微信

扫一扫关注微信